Da un paio di mesi a questa parte nel mondo della SEO non si fa che parlare di lui.

Lui chi? BERT ovviamente!

Cos’è BERT

BERT è il nuovo aggiornamento all’algoritmo di Google presentato a fine ottobre 2019, che riconosce il linguaggio naturale attraverso le reti neurali. Tuttavia, BERT è anche molte altre cose: un progetto di ricerca open-source, un paper accademico e un framework NLP (Natural Language Processing) prodotto da Google.

Ciò che in questo momento ci interessa sapere è che si tratta di una ulteriore, importante svolta nel campo dell’intelligenza artificiale applicata ai motori di ricerca.

Un’evoluzione che per Google ha avuto inizio nel 2013 con Hummingbird ed è poi proseguita nel 2015 con RankBrain, i due aggiornamenti all’algoritmo che hanno reso il motore di ricerca sempre più “intelligente” e abile nel capire le richieste degli utenti.

Il nome BERT non è altro che un acronimo che sta per Bidirectional Encoder Representations from Transformers.

Senza addentrarci in spiegazioni eccessivamente tecniche, diciamo che si tratta di una tecnica per la comprensione e l’elaborazione del linguaggio naturale basata sulle reti neurali. Una rete neurale artificiale è un modello al computer che imita il funzionamento dei neuroni del nostro cervello e il modo in cui questi funzionano tra loro.

Nel video a questo indirizzo Britney Muller, SEO scientist di MOZ che abbiamo avuto il piacere di ascoltare all’ultima edizione di SMXL, ci spiega in modo molto semplice come nasce BERT.

Ecco un breve riassunto di quanto viene spiegato nel video: i computer hanno sempre avuto grande difficoltà nel comprendere il linguaggio umano. Da questa esigenza si è sviluppato il Natural Language Processing (NLP), cioè il campo di ricerca nell’ambito dell’intelligenza artificiale che mira a sviluppare modelli per la comprensione del linguaggio naturale, ossia la lingua che usiamo nella vita di tutti i giorni.

Proprio come gli utensili che utilizziamo in cucina per compiere diverse azioni, allo stesso modo questi modelli assolvono a specifici compiti. In questo contesto, BERT rappresenta lo strumento definitivo, che con una opportuna messa a punto è capace di assolvere a tantissimi compiti diversi di comprensione del linguaggio naturale: riconoscimento delle entità, individuazione dei legami di coreferenza, disambiguazione dei termini e altro ancora.

A cosa serve e come funziona BERT

Come illustrato da Google nel comunicato ufficiale all’interno del suo blog, quando applicato alla Search BERT aiuta il motore di ricerca a capire meglio il contesto delle parole per trovare risposte sempre più pertinenti agli intenti di ricerca degli utenti. In altre parole Google è più abile a comprendere il linguaggio naturale usato dai parlanti, cioè quello che utilizziamo comunemente per comunicare e, ovviamente, fare domande. Riesce a cogliere le sottili sfumature del linguaggio che di solito i computer non sono in grado di riconoscere, risolvendo problemi di comprensione come ambiguità e polisemia.

Per maggiori approfondimenti tecnici sul funzionamento di BERT e sul suo impatto sulla comprensione del linguaggio naturale all’interno del motore di ricerca, vi consigliamo questo articolo in inglese del Search Engine Journal. L’articolo riassume la webinar tenuta lo scorso 20 novembre (l’abbiamo seguita anche noi) da Dawn Anderson, consulente SEO internazionale e speaker per vari eventi, tra cui SMXL 2019.

Sul lungo periodo, questi aggiornamenti dovrebbero permettere agli utenti di poter effettuare le ricerche nel modo a loro più congeniale e vicino al linguaggio che usano normalmente per comunicare, lasciando da parte il “keywordese”, come Google ha ribattezzato quel modo di fare ricerca più vicino ai robot che alle persone.

Come dicevamo poco sopra, BERT è in grado di riconoscere il contesto delle parole e riesce a capire l’importanza di alcune particelle fino a questo momento non considerate.

Da leggere: Google January 2020 Core Update – Due mesi dopo

L’esempio più noto fornito da Big G è quello della ricerca “2019 brazil traveler to usa need a visa” (cioè “2019 viaggiatore brasiliano verso gli USA ha bisogno di un visto”).

Fino a poco tempo fa Google non riconosceva il valore di “to”, cioè la preposizione di moto a luogo “verso”, che indica lo spostamento in direzione di un luogo preciso. Una preposizione che in questa specifica frase ha un valore importante perché ne definisce il significato.

Cosa significava questa mancanza per gli utenti che facevano questa ricerca? Che nella SERP di Google comparivano anche risposte relative a viaggiatori che dagli USA andavano verso il Brasile, risultato per nulla pertinente con la richiesta fatta dagli utenti!

Vediamo un altro esempio:

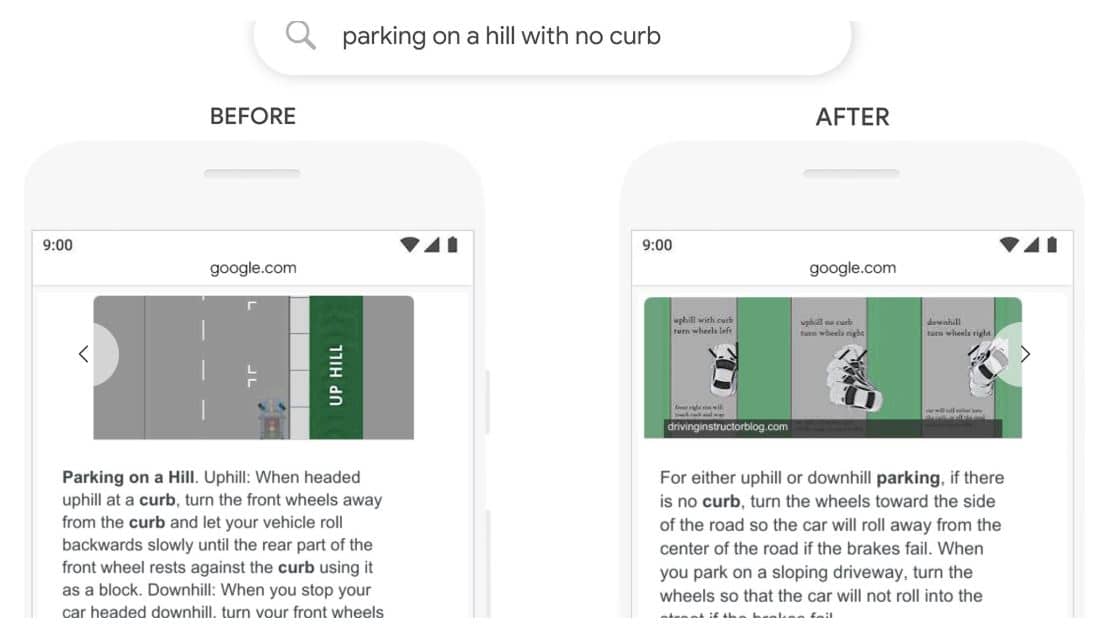

“Parking on a hill with no curb”, cioè “Parcheggio in collina senza cordolo”.

Anche in questo caso, vediamo come prima dell’avvento di BERT Google non prendesse in considerazione la particella “no” (il “senza” nella versione italiana) e desse come risposta un risultato che spiegava come effettuare un parcheggio in presenza di cordolo! Di conseguenza, non dava all’utente una risposta in linea con il suo intento di ricerca.

Come fare ottimizzazione SEO per BERT?

Togliamoci subito il pensiero: non si può ottimizzare per BERT.

Ricercatori di NLP ed esperti SEO sembrano concordare tutti sul fatto che non ci sarà molto da fare per chi si occupa di ottimizzazione.

Infatti, di per sé BERT non andrà a toccare tanto chi fa SEO, quanto le modalità che Google utilizza per interpretare le query di ricerca e comprendere il contesto di una frase. Dal punto di vista tecnico c’è quindi poco da fare; l’unico accorgimento, se vogliamo, sarà curare ulteriormente i contenuti.

Cosa può fare chi produce contenuti per un sito web o per un blog? Vale il ripetuto adagio:

“Scrivi prima per gli utenti che per i motori di ricerca”

Scrivere contenuti di qualità e cercare di rispondere nel modo più esaustivo agli intenti di ricerca delle persone.

Rendi felice il tuo lettore, dai al tuo potenziale cliente le risposte alle sue domande e vedrai che Google ti premierà. Certo la SEO non è una scienza esatta e richiede un approccio trial and error, fatto di prove ed errori, ma se fatta con criterio i risultati sul medio-lungo periodo non tarderanno ad arrivare. Chi ha sempre scritto testi pensando alle persone prima che a Google può stare tranquillo.

I SEO italiani possono dormire sonni tranquilli (per ora)

Veniamo ora alla fatidica domanda: quindi cosa cambia per la SEO in Italia con BERT?

Secondo le dichiarazioni fatte da Google, BERT inciderà sul 10% delle ricerche, sui risultati organici nelle SERP e sui featured snippet in lingua inglese.

Esatto, per il momento possiamo tirare un sospiro di sollievo, perchè BERT interesserà solo le ricerche in lingua inglese. Per cui nessun allarmismo: ci vorrà ancora qualche mese perché i sistemi neurali per il riconoscimento del linguaggio naturale diventino applicabili anche ad altri idiomi.

BERT rappresenta sicuramente un cambiamento epocale ma è ancora lontano dal comprendere il linguaggio naturale al pari di un umano e richiederà ulteriori aggiustamenti e migliorie per arrivare ad una piena comprensione.

Fino ad allora, tutto quello che possiamo fare è continuare a creare contenuti curando prima di tutto qualità, rilevanza e pertinenza alle ricerche dei nostri utenti, in attesa che le novità di oltreoceano arrivino anche da noi.

Aggiornamento 10/12/2019: BERT è ufficialmente arrivato in Italia

Attraverso un comunicato sul suo profilo Twitter Google SearchLiaison, Google ha annunciato il rilascio del nuovo aggiornamento per altre 70 lingue, tra cui l’italiano. Big G spiazza tutti e integra BERT prima del previsto anche sul mercato Italia. Non ci resta che attendere e osservare come cambieranno le SERP del 2020, si preannunciano interessanti novità!

"*" indica i campi obbligatori